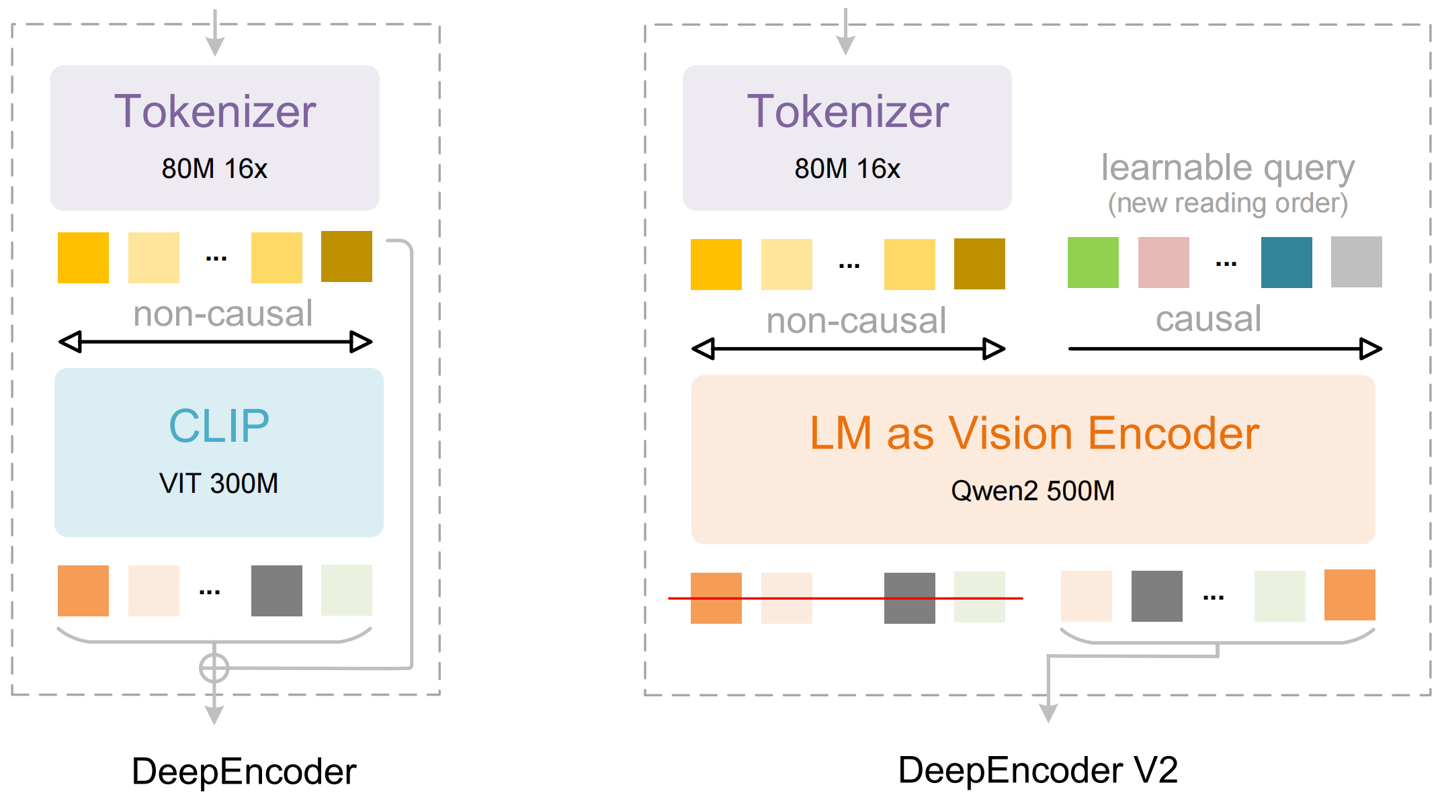

1月27日,DeepSeek发布了其最新升级的文档识别模型DeepSeek-OCR2。该模型在DeepSeek-OCR的基础上进行了核心升级,主要变化在于视觉编码器设计。研究团队提出了DeepEncoderV2新型编码器结构,能够根据图像语义动态调整视觉信息处理顺序,使模型在文字识别前先对视觉内容进行智能排序。这项技术突破源于对传统视觉语言模型处理方式的重新思考,旨在让机器更贴近人类的视觉阅读逻辑。

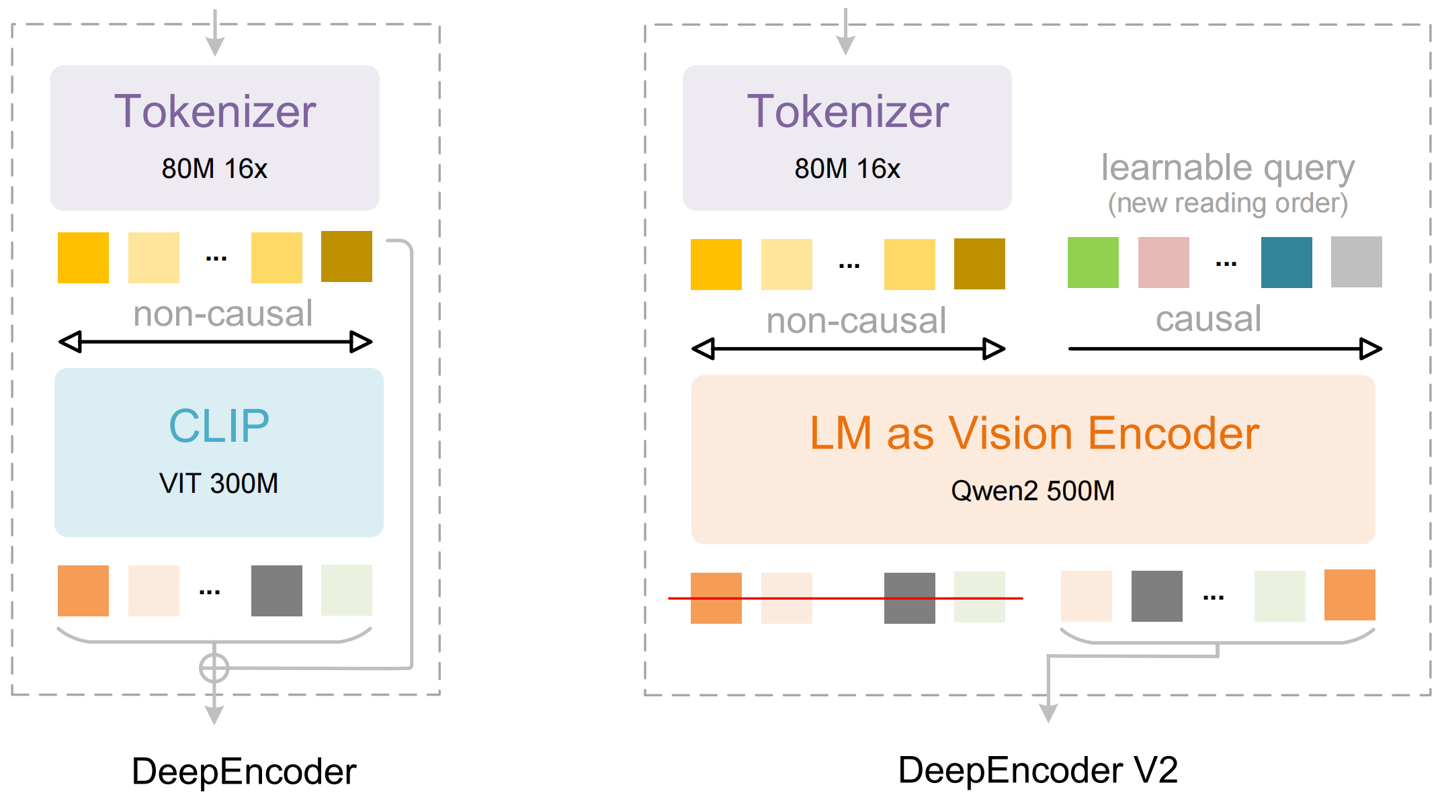

DeepSeek-OCR2引入了“视觉因果流”概念,用类语言模型结构替代了原先基于CLIP的视觉编码模块,并在编码器内部引入可学习的“因果流查询token”。编码器同时包含双向注意力与因果注意力两种处理模式,原始视觉信息通过双向注意力进行全局感知,而新增的查询标记则通过因果注意力逐步建立语义顺序,从而在编码阶段对视觉token的顺序进行动态重排。

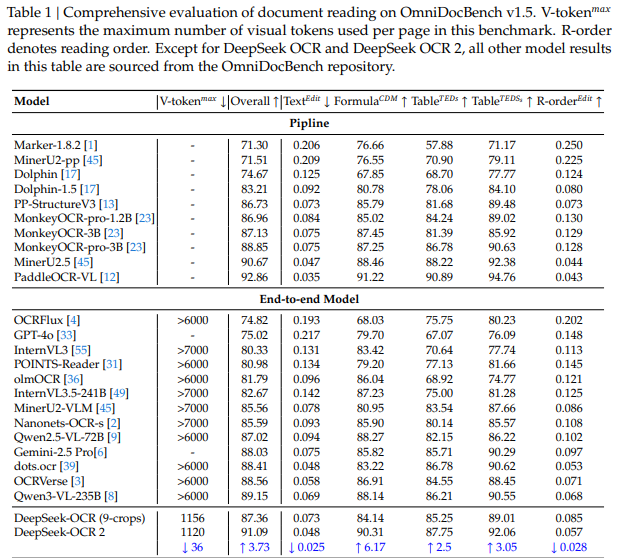

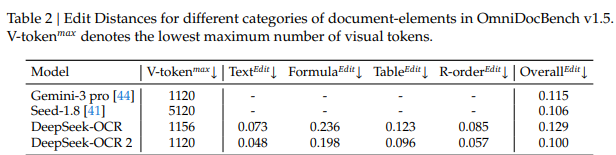

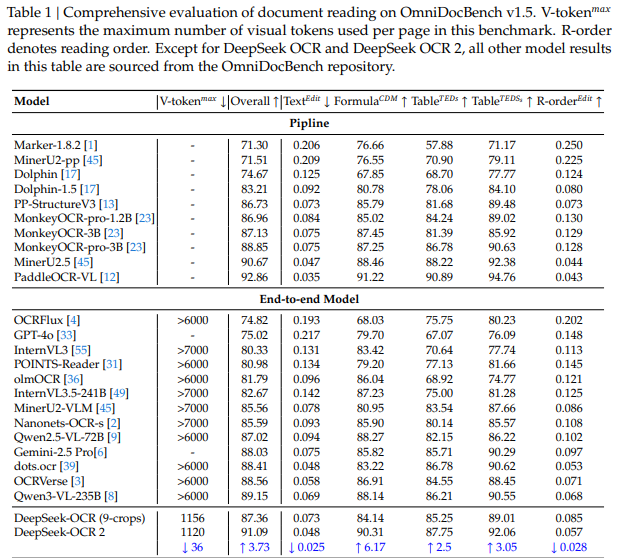

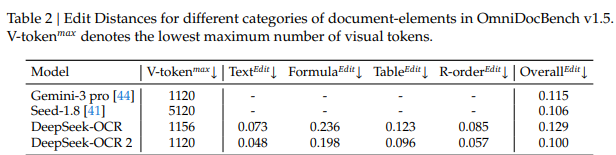

在性能测试中,DeepSeek-OCR2在OmniDocBenchv1.5基准上的整体得分达到91.09%,相较前代模型提升了3.73%。特别是在阅读顺序准确度方面,编辑距离从0.085降至0.057,表明新模型能够更合理地理解文档内容结构。此外,DeepSeek-OCR2在生产环境中也表现出更好的稳定性,在线用户日志图像的重复率和批处理PDF数据的重复率均有所降低。

来源:一电快讯

返回第一电动网首页 >

以上内容由AI创作,如有问题请联系admin#d1ev.com(#替换成@)沟通,AI创作内容并不代表第一电动网(www.d1ev.com)立场。

文中图片源自互联网或AI创作,如有侵权请联系邮件删除。